Коли підприємець стикається з різким падінням трафіку і не може знайти причину самостійно, вона звертається в інтернет-маркетингове агентство. У подібних випадках пошукові маркетологи починають роботу з аудиту сайту. Комплексна перевірка необхідна для визначення причин падіння відвідуваності і планування способів вирішення проблем.

Виконуючи аудит, пошукові маркетологи багаторазово перевіряють сайт за допомогою різних сервісів та інструментів, що дозволяють виявити технічні проблеми. Ці проблеми часто призводять до різкого падіння органічного трафіку.

Завершивши перевірку, маркетологи пропонують клієнтам звіт про знайдені помилки і план щодо їх усунення. Теоретично, з цього моменту починається відновлення позицій сайту. Однак якщо власники сайту реалізують план виправлення помилок самостійно, вони можуть зіткнутися з додатковими труднощами. Некоректна імплементація плану не тільки не приносить бажаного результату, але і погіршує ситуацію. Примітно, що власники сайта можуть не помічати своїх помилок, звинувачуючи інтернет-маркетингове агентство в неефективності аудиту та плану розвитку ресурсу.

Щоб вирішити цю проблему, маркетологи повинні контролювати дії власників сайту. Це можна робити за допомогою спеціальних сервісів і програм, а також ручної перевірки ресурсу. Як це допомагає виправляти помилки й уникати серйозних невдач? Читайте нижче.

Як повторні перевірки допомагають швидко знайти технічні проблеми: 5 прикладів

Повторні сканування і ручні перевірки дозволяють своєчасно знаходити технічні проблеми і вирішувати їх. Наступні приклади з практики інтернет-маркетингового агентства G-Squared Interactive показують важливість використання принципу «довіряй, але перевіряй»:

Клоакінг і переоптімізація внутрішніх посилань

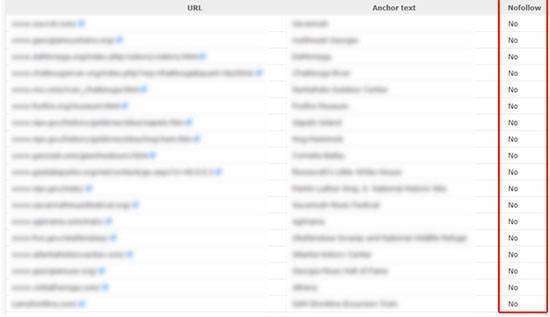

В американське інтернет-маркетингове агентство G-Squared Interactive звернувся власник великого сайту, налічує кілька мільйонів сторінок. В ході аудиту експерти агентства встановили, що пошукові проблеми ресурсу пов’язані з надмірною кількістю і переоптимизацией внутрішніх посилань. Фахівці рекомендували спростити навігацію і скоротити кількість лінків.

Через деякий час власник сайту повідомив пошуковим маркетологам, що природна відвідуваність сайту залишилася низькою, незважаючи на виконання рекомендацій. Відвідавши сайт, експерти компанії побачили, що навігація дійсно стала простіше, а число посилань зменшилася. Однак пошукові системи не підвищили позиції сайту у видачі після внесення змін. Тому фахівці вирішили перевірити сайт за допомогою інструментів для веб-майстрів Google.

.jpg)

В ході перевірки з’ясувалося, що власник сайту сховав складну навігацію і переоптімізірованниє посилання від користувачів, але не вилучив їх з сайту. Лінки залишилися видимими для пошукових роботів.

Пошукові системи застосовують жорсткі санкції по відношенню до ресурсів, що допускає клоакінг або відображення різних даних для пошукових роботів і користувачів. В даному прикладі власники сайту уникли санкцій, так як експерти агентства вчасно виявили порушення політики пошуковиків. Приховані посилання та переходи були вилучені протягом декількох годин, після чого позиції сайту у видачі відновилися.

Партнерський маркетинг

Власник інформаційного ресурсу, що налічує 1,5 млн. сторінок, звернувся в агентство з-за санкцій, отриманих після впровадження алгоритму Google Panda. Власник заробляв кошти з допомогою демонстрації рекламних оголошень і партнерського (афілійованого) маркетингу. Саме відкриті для індексації партнерські посилання стали причиною пенальті Panda.

Виконавши аудит, фахівці агентства запропонували об’єднати партнерські посилання сайту в дві групи. У першу групу пропонувалося включити лінки, які не приносять доходу. У другій групі повинні були залишитися посилання, які важливі для власника з фінансової точки зору. На думку пошукових маркетологів, всі посилання першої групи слід видалити. Лінки другої групи пропонувалося закрити атрибутом nofollow. Також фахівці агентства рекомендували додаткові кроки щодо підвищення якості ресурсу.

Через кілька тижнів пошукові маркетологи повторно перевірили сайт. На перший погляд, власник ресурсу точно втілив рекомендації фахівців. Він видалив старі партнерські посилання і закрив нові атрибутом nofollow. Однак експерти виявили кілька сторінок, що містять багато відкритих для індексації зовнішніх лінків.

В ході бесіди з власником ресурсу з’ясувалося, що коли-то він створив і опублікував власний каталог партнерських посилань. Потім власник благополучно забув про цих лінках. Після додаткового обговорення власник ресурсу видалив частину посилань зі свого каталогу, а решта закрив атрибутом nofollow. Цього виявилося достатньо для скасування санкцій Panda.

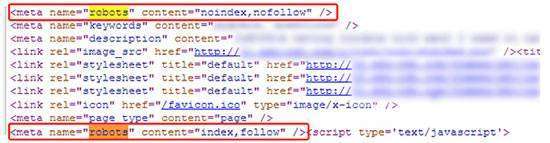

Дублювання метатега Robots

Неправильне використання метатега Robots може призвести до катастрофічних наслідків для сайту з точки зору SEO. Це підтверджується наступним прикладом з практики згаданого вище агентства. До пошукових маркетологам звернувся власник інтернет-магазину, який не міг домогтися індексації всіх сторінок сайту пошуковими системами. В ході аудиту експерти швидко з’ясували, що краулеры обходять ті сторінки сайту, у метатеге Robots яких вказано значення noindex, nofollow. Фахівці рекомендували власнику сайту відкрити сторінку для індексації.

Однак після виконання рекомендацій пошукові роботи так і не проіндексували сторінки. Повторна ручна перевірка HTML-коду сайту виявила дублювання метатегів Robots. При цьому в першому метатеге індексування було відкрито, а в другому закрито.

Як відомо, при дублюванні команд пошукові роботи вибирають найбільш обмежуючі правила. Тому в розглянутому випадку сторінки сайту залишилися непроиндексированными. Видаливши повторювані метатеги Robots, власник сайту швидко домігся індексації сторінок.

Дублювання заголовків сторінок

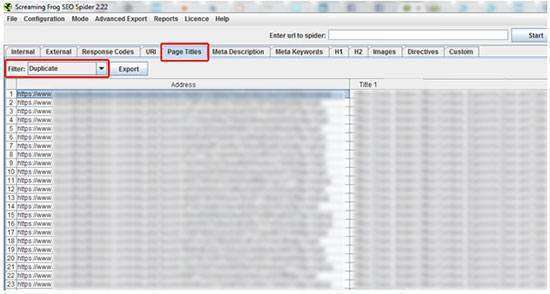

Переоптімізація або некоректне використання заголовків і метаданих відносяться до найбільш поширених причин зниження позицій сайтів у видачі. У цьому можна переконатися на прикладі інформаційного сайту, власник якого довгий час не міг зрозуміти причини падіння трафіку. Більш того, аудитори маркетингового агентства також не змогли з першого разу знайти помилки.

Зрештою аналіз результатів сканування сайту з допомогою програми Screaming Frog допоміг визначити дублювання заголовків сторінок. Через недосконалість CMS в кожній категорії сторінки другого рівня мали загальний title, що збігається з заголовком сторінки категорії першого рівня.

Таким чином, сотні або навіть тисячі сторінок з однаковими заголовками стали причиною низьких позицій сайту у видачі. В даному випадку ця помилка не призвела до пенальті. Проте пошуковики не вважали сторінки з неуникальными title релевантними запитам користувачів.

Власник сайту вніс необхідні зміни в CMS, після яких кожна сторінка другого рівня отримала унікальний заголовок. Після цього природний трафік на сайт відновився.

Канонічні URL

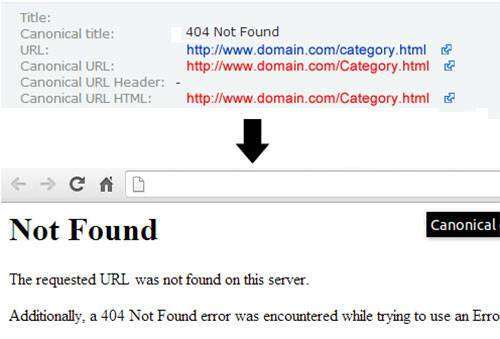

Використання канонічних URL допомагає уникнути дублювання контенту. Однак невірне використання атрибуту rel=»canonical» іноді призводить до катастрофічних наслідків для сайтів.

Власник інтернет-магазину звернувся в маркетингове агентство з традиційною скаргою на падіння трафіку. В ході аудиту пошукові маркетологи виявили непослідовне використання канонічних URL. Частина сторінок сайту мали відповідний атрибут, а на інших він був відсутній.

Експерти рекомендували власнику ресурсу додати канонічні URL на кожну сторінку. Внесення змін не викликало утруднень: власник просто додав одну сходинку в HTML-код сторінок. Однак трафік на сайт не відновився.

Повторна перевірка ресурсу виявила помилку: посилання в тезі канонічного URL містили великі і маленькі букви, тоді як оригінальні посилання містили тільки маленькі літери.

У результаті цієї помилки всі сторінки вказували в якості канонічного URL, ведучий на неіснуючі сторінки. Не дивно, що інтернет-магазин практично не отримував органічного трафіку. Власник сайту швидко вирішив проблему, виправивши помилку у посиланнях.

Довіряй, але перевіряй

Довіра — обов’язкова умова успішного співробітництва маркетологів і власників сайту. Однак якщо клієнти віддають перевагу реалізовувати плани розвитку сайтів самостійно, фахівцям по пошуковому просуванню варто контролювати їх дії. Це необхідно хоча б для того, щоб уникнути звинувачень у неякісному проведенні аудиту та пропозиції неефективних кроків з оптимізації сайту.

Маркетологи можуть перевіряти сайти за допомогою сервісів і програмних засобів. Наприклад, вони можуть скористатися інструментами для веб-майстрів Google і «Яндекс», Google Analytics і Яндекс.Метрикою», програмами Netpeak Spider, Screaming Frog та іншими засобами. Також фахівцям необхідно оцінювати внесені зміни вручну, вибірково перевіряючи код сторінок і результати видачі.

Як ви вважаєте, чи можуть власники сайтів самостійно працювати з сайтами рекомендації маркетологів? Повинні маркетологи в цьому випадку контролювати клієнтів?

Дмитро Дементій, переклад матеріалу 5 Examples of How Recrawling Site Changes Can Nip SEO Problems in the Bud by Glenn Gabe.

Читайте також:

- 9 уроків від генія вірального вмісту

- Як вибрати найбільш відповідає вашим завданням варіант тексту для сайту?

- 8 харизматичних способів залучити користувачів facebook’а у взаємодію з вашим брендом