Поки SEO-ринок обговорює, чи в «Яндексі» відкат від бессылочных алгоритмів або не буде, поговоримо про таку річ, як deep learning (і потім не кажіть, що не чули).

Чому про це треба знати? Тому що deep learning – це революція в машинному навчанні, яка відбувається на наших очах. І найближчим часом deep learning змінить до невпізнанності і сам пошук, і ранжування природної видачі, і наш світ в цілому (не багато, не мало).

Отже, що таке deep learning? У російській мові цей термін поки ще не усталений, і переводять його по-різному. Мені більше подобається переклад «глибинне навчання» (а не «глибоке»), яке запропонував у якості основного один з російських фахівців Дмитро Вітрів.

«Глибинне навчання» – це різновид машинного навчання, в основі якої лежать нейронні мережі. Сьогодні на використанні «глибинного навчання» будуються системи розпізнавання мови, розпізнавання візуальних об’єктів (як статичних, так і рухомих) і, нарешті, взаємодія комп’ютерних систем з природною мовою і вичленовування смислів.

Начебто все просто, все зрозуміло, і – начебто – нас з вами не стосується. Але… Але насправді, мова йде про справжньої революції в області машинного навчання. Вона почалася не вчора, загальні принципи «глибинного навчання» існують досить давно. Але фактичне втілення deep learning стало можливо на початку нинішнього десятиліття, коли значно подешевшало створення комп’ютерних нейромереж. І починаючи приблизно з 2012-го року в машинному навчанні відбувається справжній бум, пов’язаний з технологіями «глибинного навчання». Тим не менш, до цих пір фахівців з «глибинного навчання» у світі дуже мало, а потреба в них дуже висока. Наприклад, алгоритм розпізнавання сенсу в текстах створив практично одна людина – Thomas Mikolov. На той момент він працював в Google, але практично відразу ж після цього його «схантил» Facebook.

Читайте також: LSI-копірайтинг – тренд найближчого часу

Вище я вже сказав, що «глибинне навчання» – це різновид машинного навчання. Але це не зовсім так, насправді. Класичне машинне навчання – це витяг нових знань з великого масиву даних, які завантажує в машину чоловік. Людина формулює правила навчання машини (за рахунок т. н. «навчальної вибірки»), і править помилки машини (усуває ефект т. н. «перенавчання»). Але у класичного машинного навчання є істотні недоліки – дані для обробки та приклади рішення даються машині людиною. Іншими словами, в класичному машинному навчанні комп’ютер виконує велику кількість завдань, але не формує ці завдання самостійно. Концепція «глибинного навчання» припускає, що машина сама створює собі функціонал, наскільки це тільки можливо на поточний момент часу.

Саме поняття «глибина» у застосуванні до машинного навчання передбачає моделювання многоуровненных абстракцій («шарів») і переведення їх у дані. Чим більше цих «шарів» («глибин»), тим більше високоінтелектуальні завдання може виконувати нейронна мережа. При цьому вона виконує їх без допомоги людини.

По суті, «глибинне навчання» – це перший і досить великий крок в сторону штучного інтелекту. Нейронні мережі – це системи, які, хай поки примітивно, але можуть думати, тобто створювати нові відкриття з даних, які вони самі для себе створили. Механізм багаторівневих абстракцій («шарів»), що використовується в глибинному навчанні, дуже схожий на механізм навчання людського дитинчати. Як дитина спочатку вивчає звуки, потім окремі слова, і тільки потім пропозиції – «глибинна» нейронна мережа рухається від простих (поверхневих) абстракцій до більш складним.

Революція deep learning

Весь 2012 і 2013 роки Google тихо, але методично скуповує діючі фірми і стартапи в області deep learning. Серед них були досить великі компанії (наприклад, вартість британської DeepMind за словами експертів на момент покупки пошуковим гігантом коливалася в межах 400-500 млн. доларів США), так і зовсім карликові – наприклад, DNNresearch, в якій на момент покупки компанії Гуглом працювало лише три співробітника – Джеффрі Хінтон і два його аспіранти.

Хінтон, професор Торонтського університету, почав свої дослідження в області побудови нейронних мереж ще в 80-ті роки минулого століття і, фактично, є сьогодні найбільш авторитетним фахівцем в світі за deep learning. Саме на наукових роботах Хінтона базувалися багато систем, що використовують «глибинне навчання». У 2011-му році Google створює свою першу нейронну мережу, що отримала назву Google Brain (її розробляє вже стало культовим підрозділ Google X), і спочатку Хінтон бере участь у розробці нейромережі в якості найманого консультанта, а двома роками пізніше разом зі своїми аспірантами приєднується до команди Google Brain (не залишаючи при цьому свою викладацьку діяльність в Університеті Торонто).

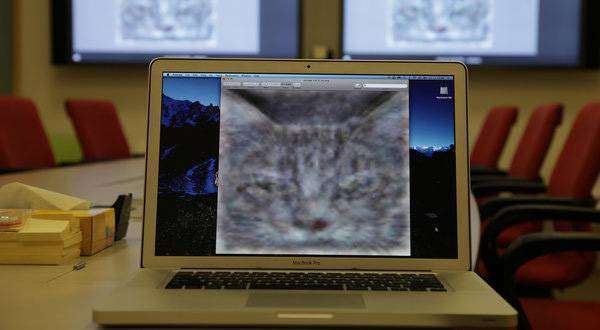

Нейронна мережа Google Brain (у 2012-му році вона складалася з 16 тис. процесорів) починає навчатися. Попутно вирішуючи прикладні завдання – наприклад, саме завдяки нейронної мережі кількість помилок розпізнавання голосових команд в пошуку зменшилася на 25%, – вона відкриває для себе таке істота, як кішка.

Просто вивчаючи мільйони зображень на каналі Youtube штучна нейромережа відкрила кішку. Насправді рішення подібної задачі – архіскладне річ, тому що важко формалізується. Можна створити алгоритм, який буде розпізнавати кішок на певних типах фотографій (зі схожим ракурсом, зі схожими розмірами об’єктів). Можна створити алгоритм, який буде малювати цих кішок. Але як створити алгоритм, який буде розпізнавати кішок в будь-якому ракурсі, якщо він, алгоритм, не розуміє, що таке кішка?

Нейронна мережа повинна була почати розуміти це. І вона цього навчилася. Навчилася сама, людина не ставив їй такої задачі.

Зрозуміло, що поки що все ще не так все райдужно. Нейронна мережа відрізняє кішок на зображеннях тільки в 15% випадків. Точність може бути набагато вище, якщо мережа буде вивчати однотипні матеріали. Тобто, фактично, точність розпізнавання кішок нейронною мережею в даний час значно гірше, ніж розпізнавання кішок 4-5 летимо дитиною. Але нейронну мережу, на відміну від дитини, ніхто не навчав ніхто не показував об’єкти з кішкою, називаючи їх. Мережа народила концепт кішки самостійно.

Що буде далі

У березні 2015 року в світі SEO вибухнула ядерна бомба» – Google опублікував статтю «Довіра, засноване на знаннях: оцінка надійності веб-ресурсів». Безперечно, я перебільшую, новина, насправді, пройшла непомітно. Ну, пару днів сеошники пообурювалися і поскептицировали – вибачаюся за це безглузде слово, але я не знаю, як ще позначити бурління на сеошних форумах і в групах соцмереж. Обуренню («знову Гугл на нас ставить досліди») і скепсису («нічого у нього не вийде, як і у Яші з відміною посилального») не було меж. Воно й зрозуміло, в суто науковій статті представники Гугла проанонсували новий алгоритм ранжування, заснований на не посилальної авторитетності документа, а на фактологічної достовірності. Якщо спрощено, то суть нового алгоритму можна виразити такою сентенцією: документ з достовірною фактологией при інших рівних повинна ранжуватися вище документа з недостовірної фактологией.

Скепсис сеошників загалом зрозумілий – вони (як, втім, і завжди) побачили тільки те, що захотіли побачити. І основне питання, яке ставилося на форумах, звучала приблизно так: «Це що ж, чорт вас всіх дері, виходить – тепер ми повинні створювати контент, який буде наводити факти з Вікіпедії чи інших авторитетних джерел, навіть якщо вони на сторінці зовсім не доречні?».

Але справа в тому, що новий алгоритм не може працювати без розуміння сенсу сказаного на сторінці. Розуміння смислів написаного/озвученого тексту на сторінці, а не розпізнавання семантики – ось що зробить пошук невпізнанним.

Як «глибинне навчання» буде працювати в пошуку? Звернуся до досвіду людей, які розбираються в цьому набагато краще за мене. Ось що говорить Ренд Фишкин у черговому випуску Whiteboard Friday (до речі, цей випуск так і називається – «Що значить глибинне навчання і машинне навчання для майбутнього SEO?»):

«Нейронна мережа складається з різних шарів. Перший шар буде виявляти всілякі особливості документа. Інший шар нейромережі буде класифікувати типи цих особливостей. Таким чином Google буде враховувати всі можливі особливості будь-якого типу сайтів і будь-якого типу сторінок для того, щоб вирішувати: а які корисні сигнали взагалі можна отримати прямо тут і зараз? При цьому нейронна мережа буде враховувати накопичені дані про поведінку користувачів на всіх сторінках інтернету (куди вона зможе дотягнутися) для того, щоб прогнозувати результати – сподобається той чи інший документ користувачеві у видачі чи ні.

Але основна ідея полягає в тому, що в майбутньому вхідні дані не будуть контролюватися людиною. Машина сама буде намагатися зрозуміти зміст сторінки. Так, це дивно звучить. Але незабаром, якщо ви запитаєте інженера Google – наприклад, чи варто продовжувати нарощування вхідних посилань на сайт? – він вам, швидше за все відповість: не знаю. Вони, дійсно, перестануть знати, які саме сигнали виділяє пошуковий алгоритм для певного запиту та певного типу сторінок. Тільки машина буде знати це, але вона пояснити нікому нічого не зможе, тому що алгоритм ранжирування буде постійно видозмінюватися в міру появи нових документів з цієї тематики, і багато метрики, які будуть використовуватися нейромережею, будуть похідними похідних великої кількості інших метрик».

Читайте також: Як створювати і поширювати ідеї

«Глибинне навчання» наступає

Революція deep learning, по суті, тільки починається. Але вже сьогодні нейронні мережі з використанням «глибинного навчання» функціонують.

Наприклад, на технологіях deep learning працюють сервіси моніторингу дорожніх пробок. Так, «Яндекс.Пробки» не лише відображає реальну картину, але і намагається прогнозувати появу корків, а без deep learning таке прогнозування неможливо.

Голосовий пошук Google і Apple Siri працює на технологіях «глибинного навчання».

Сервіс Google прогнозування розповсюдження грипу працює на методиках deep learning.

Алгоритми розпізнавання людей на фото і відеозображеннях, які щодня завантажуються в Facebook, працюють на технологіях deep learning.

Для пошуку. Алгоритми персоніфікації пошукової видачі працюють на технологіях deep learning.

Ми входимо у новий чудовий світ. І найближчі п’ять років будуть воістину революційними – не тільки для пошукового маркетингу, але й для людства в цілому. Дуже скоро ми все це побачимо на власні очі.