Спліт-тести допомагають оптимізувати конверсію. З їх допомогою маркетологи перевіряють ефективність змін посадкових сторінок, конверсійних форм та інших елементів сайтів. Проте A/B-тести можуть призводити до різкого падіння коефіцієнта конверсії та скорочення продажів. Як це відбувається? Читайте нижче.

У чому сенс спліт-тестування

A/B-тест — це дослідницький спосіб, що дозволяє оцінювати ефективність змін на сайті. Одночасно спліт-тест є прикладним маркетинговим методом підвищення ефективності веб-сторінок. A/B-тестування виконується за допомогою спеціальних сервісів, наприклад, Content Experiments, Visual Website Optimizer або Optimizely.

Суть A/B-тесту полягає в наступному:

- Ви досліджуєте ефективність сторінки та формулюєте гіпотезу.

- Щоб перевірити гіпотезу, ви створюєте тестову сторінку.

- За допомогою спеціального сервісу ви розподіляєте трафік між вихідною і тестовій сторінкою сайту.

- Через певний час ви порівнюєте параметри контрольної і тестовій сторінок. Це дозволяє підтвердити або спростувати гіпотезу.

Дуже часто результати спліт-тестів виявляються несподіваними. Наприклад, коефіцієнт конверсії може зрости після видалення зі сторінки відгуків вдячних клієнтів, а кількість замовлень може збільшитися після заміни агресивного CTA «Підпишіться на розсилку прямо зараз» на нейтральний текст «Хочу отримувати інформацію про нові товари і знижки».

Іноді A/B-тест не просто фіксує неефективність змін, а призводить до негативних результатів для бізнесу. Це трапляється із-за маркетингових або технічних помилок.

Як спліт-тест може обрушити конверсію: міні-кейс

Власник популярного англомовного блогу про інтернет-маркетингу вирішив перевірити ефективність екранної форми підписки на email-розсилку. Він створив тестовий варіант форми підписки і розподілив порівну трафік між контрольною і тестовій формами за допомогою сервісу AWeber. Через добу блогер перевірив результати експерименту. У звіті він побачив наступну картину:

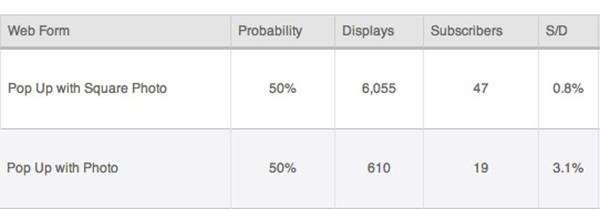

У верхньому рядку відображаються результати тестового варіанту, а в нижній контрольного. Результати тестування вимагають розшифровки:

- Probability: в цій колонці відображається запланований розподіл трафіку між текстовою і контрольними сторінками.

- Displays: користувачі побачили тестовий варіант 6055 раз, а контрольний 610.

- Subscribers: тестовий варіант приніс 47 підписок, а контрольний 19.

- S/D: відсоткове співвідношення кількості підписок до числа показів.

Не потрібно мати вчений ступінь, щоб зрозуміти, що результати тесту не можна вважати валідними. Незважаючи на плани експериментатора розподілити трафік порівну між тестової та контрольної сторінкою, варіант із змінами набрав майже в 10 разів більше переглядів. Як виявилося, це відбулося із-за технічного збою на платформі AWeber.

Здавалося б, власник блогу може перевести дух, дочекатися повідомлення про виправлення неполадок і заново запустити експеримент. Але здорова прискіпливість може змусити його ще раз подивитися на співвідношення S/D базової сторінки та кількість показів тестової сторінки. Чорт візьми, якщо б платформа зламалася в іншу сторону, то 6055 показів могли конвертуватися в 187 підписок. Усвідомивши втрату сотні передплатників за добу, блогер може сильно засмутитися і втратити віру в спліт-тестування.

Насправді, від технічних збоїв ніхто не застрахований, а A/B-тести залишаються ефективним маркетинговим засобом, незважаючи на описаний вище казус. Однак спліт-тести можуть показувати помилкові результати і приводити до падіння конверсії через маркетингових помилок.

Коли спліт-тести призводять до втрат з вини експериментатора

Експеримент стає проблемою для сайту і бізнесу, коли маркетолог допускає серйозні помилки на стадії планування. Нижче описані найбільш поширені помилки експериментаторів.

- Створення умов, сильно спотворюють хід експерименту

Як ви думаєте, який текст стане більш конверсійним: «додати товар у кошик» або «оформити замовлення»? Відповідь на це питання можна отримати в ході спліт-тесту. А який CTA виявиться більш вдалим для форми підписки: «підпишись на нашу розсилку» або «залиш Email і отримай 1000 рублів на рахунок Webmoney»? Ви знаєте відповідь на це питання без A/B-тесту.

Проблема не в тому, що результати експерименту будуть спотворені. 99 % абонентів, які підписалися заради 1000 халявних рублів, отпишутся від вашої розсилки протягом декількох днів. Вони не зроблять цього відразу ж після отримання грошей тільки з-за побоювань, що ви будете снитися їм ночами і качати головою з докором. Виходить, ця помилка небезпечна не стільки з-за спотворення результатів експерименту, скільки з-за отримання помилкових переходів.

- Недостатня величина вибірки

Багато сервісів для проведення A/B-тестів дозволяють довільно визначати частку трафіку, що бере участь в експерименті. Якщо ви допускаєте до участі в експерименті незначна кількість відвідувачів, це значно збільшує терміни, необхідні для отримання валідного результату. Але це ще не все.

Уявіть собі наступну ситуацію: ви тестуєте новий дизайн сторінки. В експерименті бере участь 5 % відвідувачів, які направляються на тестову сторінку. Ви нікуди не поспішаєте, тому не хочете ризикувати. Через місяць з’ясовується, що коефіцієнт конверсії тестової сторінки в 2,5 рази перевищує аналогічний показник контрольної. Вивихнутий у спробі вкусити себе за лікоть плече нічого не значить у порівнянні з недоотриманим прибутком. Втрати можна було б значно скоротити, розподіливши трафік інакше на початку експерименту.

- Тестування різних елементів сторінки

Уявіть, що ви тестуєте новий варіант тексту для конверсійної кнопки. В останній момент дизайнер вирішує ще й змінити колір самої кнопки на тестовій сторінці. В ході експерименту з’ясовується, що нова сторінка є в два рази більше конверсійної порівняно зі старою. Ви приписуєте цей ефект нового тексту і видаляєте старий варіант.

Через деякий час ви помічаєте, що конверсія сторінки впала на 50 %. Піймавши в курилці дизайнера, ви видавлюєте з нього щиросердне зізнання про зміну кольору кнопки. Тепер ви можете пояснити зростання конверсії в ході тесту. Більш того, ви розумієте, що втратили час і клієнтів, так як новий текст конверсійної кнопки виявився менш ефективним порівняно зі старим.

- Невірний вибір метрик

Уявіть, що ви тестуєте ефективність конверсійних кнопок, які запрошують користувача скачати безкоштовну електронну книгу. В даному випадку конверсією можна вважати клік по кнопці, після якого книга починає автоматично завантажуватися на жорсткий диск відвідувача. Ви будете оцінювати результати тесту по CTR кожного варіанту кнопок.

А як оцінити ефективність конверсійної кнопки, запрошує додати товар у кошик або оформити замовлення? Клік по кнопці не дорівнює конверсії, так як додавши товар у кошик, користувач може передумати. Можливо, ефективність кнопки варто оцінювати за кількістю завершених угод? Чи можлива ситуація, коли кнопка з більш високим CTR генерує менше завершених угод? Завдасть шкоди бізнесу ситуація, в якій ви помилково вважаєте більш ефективної кнопку з високим CTR і низьким показником оплат?

Сильне ліки в руках недосвідченого, як гострий меч у руках божевільного

Лікарі давнину застерігали цими словами початківців колег від бездумного використання ліків. A/B-тест — це сильне маркетингове ліки, яке приносить користь тільки при правильному застосуванні. Помилки спліт-тестування можуть коштувати вам не тільки втраченого часу, але і падіння конверсії і продажів. Будьте уважні!

Адаптація матеріалу How A/B Testing Can Lead to a Dramatically Lower Conversion Rate, what’s Wrong With A/B Testing, Three Common Ways A/B Testing Goes Wrong та інші.

Читайте також:

- Як вибрати найбільш відповідає вашим завданням варіант тексту для сайту?

- 62 змінних для А/Б-тестування

- Як редагування тексту впливає на рівень конверсії: аналіз 8 простих прикладів з результатами реальних А/Б-тестів